AI thế hệ mới: Khi máy móc biết tư duy và hành động độc lập?

Đúc kết của giáo sư hàng đầu về AI - Ethan Mollick sau sự ra mắt của Deep Research-một bước tiến quan trọng của Open AI cuối tuần qua.

Một dấu hiệu của tương lai đã lặng lẽ xuất hiện vào cuối tuần qua. Trong một thời gian dài, giáo sư Ethan Mollick đã thảo luận về hai cuộc cách mạng song song trong lĩnh vực AI: sự trỗi dậy của các tác nhân tự chủ (autonomous agents) và sự xuất hiện của những Bộ lý luận mạnh mẽ (Reasoners) kể từ khi OpenAI ra mắt o1. Hai xu hướng này cuối cùng đã hội tụ thành một thứ thực sự ấn tượng - các hệ thống AI có khả năng tiến hành nghiên cứu với độ sâu và sắc thái của các chuyên gia con người, nhưng với tốc độ của máy móc. Deep Research của OpenAI là minh họa cho sự hội tụ này và cho chúng ta cảm nhận về tương lai có thể xảy ra. Nhưng để hiểu tại sao điều này quan trọng, chúng ta cần bắt đầu từ hai thành phần cốt lõi: Các Bộ lý luận (Reasoners) và các tác nhân (Agents).

Các Bộ lý luận của AI (Reasoners)

Khi bạn chat với AI, nó thường trả lời ngay lập tức từng từ một (hoặc chính xác hơn là từng token một). AI chỉ có thể "suy nghĩ" trong khi tạo ra các token này, vì vậy các nhà nghiên cứu đã phát triển các thủ thuật để cải thiện khả năng lập luận của nó - chẳng hạn như yêu cầu nó "suy nghĩ từng bước trước khi trả lời". Phương pháp này được gọi là gợi ý chuỗi-suy-nghĩ (chain-of-thought prompting), đã cải thiện đáng kể hiệu suất của AI.

Các Bộ lý luận (Reasoners) về cơ bản là sự tự động hóa quá trình này, tạo ra các "token suy nghĩ" trước khi thực sự đưa ra câu trả lời. Đây là một bước đột phá quan trọng theo ít nhất hai cách. Thứ nhất, các công ty AI giờ đây có thể khiến AI học cách lập luận dựa trên các ví dụ từ những chuyên gia giải quyết vấn đề, giúp AI có thể "suy nghĩ" hiệu quả hơn. Quá trình đào tạo này có thể tạo ra một chuỗi suy nghĩ chất lượng cao hơn so với việc chúng ta gợi ý. Điều này có nghĩa là các Bộ lý luận (Reasoners) có khả năng giải quyết các vấn đề khó hơn nhiều, đặc biệt là trong các lĩnh vực như toán học hoặc logic mà các chatbot cũ thường thất bại.

Thứ hai, càng để các Bộ lý luận "suy nghĩ" lâu, câu trả lời của chúng đưa ra càng tốt hơn (mặc dù tốc độ cải thiện chậm dần khi chúng suy nghĩ lâu hơn). Đây là một bước tiến lớn vì trước đây cách duy nhất để cải thiện hiệu suất AI là đào tạo những mô hình lớn hơn, tốn kém hơn và cần rất nhiều dữ liệu. Nhưng với các Bộ lý luận, ta có thể nâng cao hiệu suất AI chỉ bằng cách cho phép chúng tạo ra nhiều token suy nghĩ hơn ngay trong quá trình trả lời (tức là tận dụng tài nguyên tính toán tại thời điểm suy luận, thay vì lúc đào tạo mô hình).

Vì các Bộ lý luận còn rất mới, khả năng của chúng đang phát triển nhanh chóng. Chỉ trong vài tháng, chúng ta đã chứng kiến những cải tiến đáng kể từ dòng OpenAI o1 lên o3. Trong khi đó, DeepSeek r1 của Trung Quốc đã tìm ra những cách sáng tạo để tăng hiệu suất đồng thời cắt giảm chi phí, và Google đã ra mắt Bộ lý luận (Reasoner) đầu tiên của họ.

“Đây chỉ mới là khởi đầu – hãy chuẩn bị cho một làn sóng các hệ thống mạnh mẽ hơn trong tương lai gần.” - Ethan Mollick

Các tác nhân AI (Agents)

Trong khi giới chuyên môn vẫn còn tranh luận về định nghĩa chính xác của một tác nhân AI (AI agent), ta có thể hiểu đơn giản: đó là một AI được giao một mục tiêu và có thể theo đuổi mục tiêu đó một cách tự chủ. Hiện tại đang có một cuộc chạy đua vũ trang giữa các phòng thí nghiệm AI để xây dựng các tác nhân đa năng - những hệ thống có thể xử lý bất kỳ nhiệm vụ nào bạn giao cho chúng. Giáo sư Ethan Mollick từng đề cập về một số ví dụ ban đầu như Devin và Claude với khả năng sử dụng máy tính, nhưng OpenAI vừa phát hành Operator, có lẽ đang là tác nhân đa năng hoàn thiện nhất cho đến nay.

Video dưới đây, được tăng tốc 16 lần, cho thấy cả tiềm năng lẫn thách thức của các tác nhân đa năng. Giáo sư đã giao cho Operator một nhiệm vụ: đọc bài đăng mới nhất của ông trên OneUsefulThing và sau đó truy cập Google ImageFX để tạo một hình ảnh phù hợp, tải xuống và đưa cho ông để đăng.

Những gì diễn ra sau đó thật sự đáng chú ý. Ban đầu, Operator hoạt động rất chính xác - tìm trang web của giáo sư Ethan, đọc bài đăng, điều hướng đến ImageFX (dừng lại một chút để ông nhập thông tin đăng nhập) và tạo hình ảnh. Nhưng rồi, những rắc rối bắt đầu nảy sinh. Có hai trở ngại lớn: không chỉ Operator bị chặn bởi các hạn chế bảo mật của OpenAI về tải xuống tệp, mà bản thân nó còn bắt đầu gặp khó khăn trong việc hoàn thành nhiệm vụ. Nó cố gắng mọi cách để vượt qua – sao chép vào clipboard, tạo đường link trực tiếp, thậm chí đào sâu vào mã nguồn trang web. Nhưng mọi nỗ lực đều thất bại - một số do hạn chế trình duyệt của OpenAI, một số do chính sự bối rối của Operator về cách thực hiện nhiệm vụ. Chuỗi thử nghiệm đầy quyết tâm nhưng thất bại này không chỉ phản ánh những hạn chế hiện tại của các tác nhân AI mà còn đặt ra câu hỏi: chúng sẽ phản ứng ra sao khi gặp rào cản trong thế giới thực?

Dù Operator còn nhiều điểm yếu, nhưng điều đó không có nghĩa là các tác nhân AI là vô dụng. Thực tế, những tác nhân chuyên biệt – chỉ tập trung vào một nhiệm vụ cụ thể – đã cho thấy tiềm năng kinh tế to lớn. Những chuyên gia AI này, tận dụng sức mạnh của các mô hình ngôn ngữ lớn (LLM) hiện tại, có thể đạt được những thành tựu đáng kinh ngạc trong lĩnh vực của mình. Minh chứng rõ nhất chính là Deep Research của OpenAI – một tác nhân AI chuyên biệt cực kỳ mạnh mẽ.

Deep Research

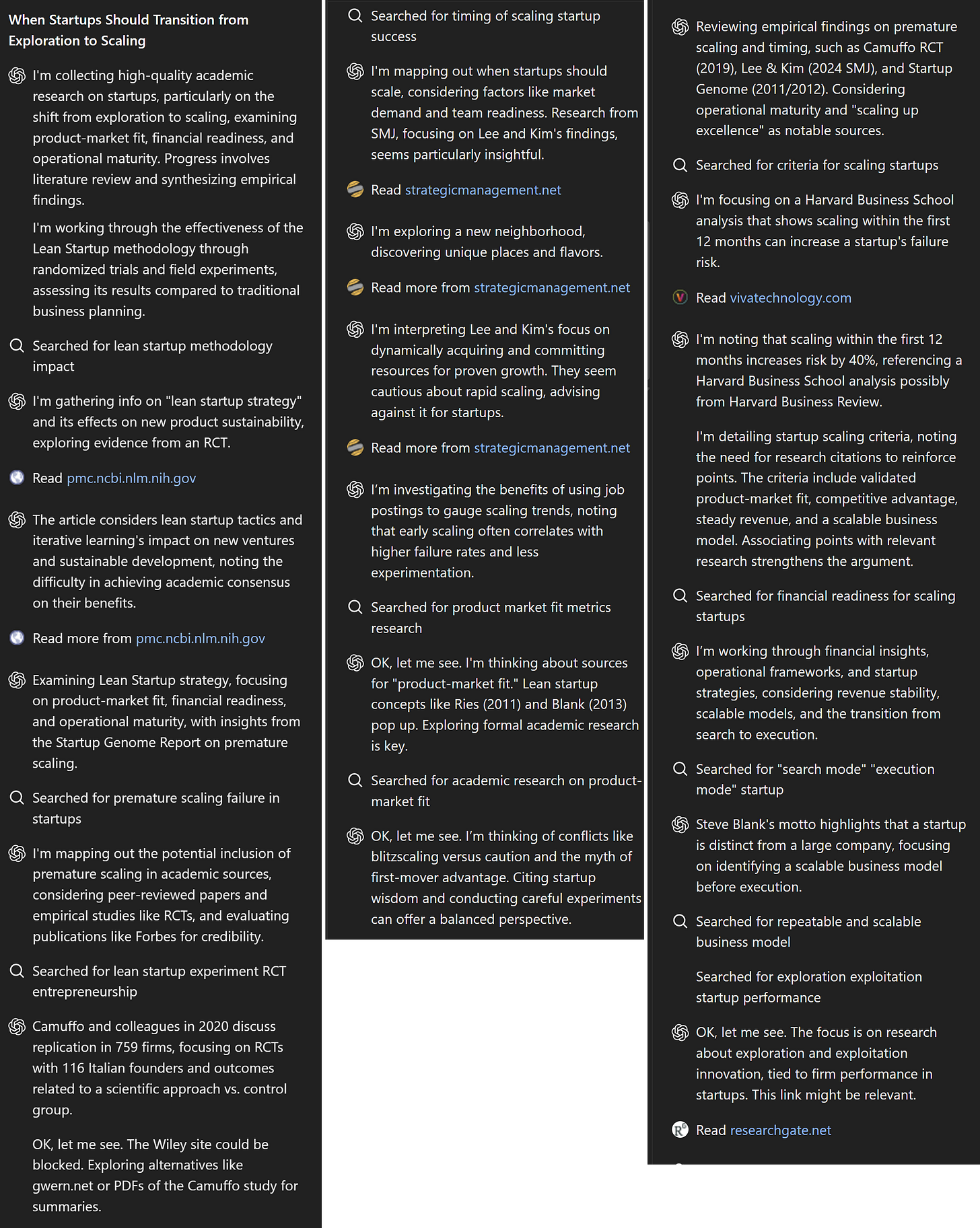

Deep Research của OpenAI (không nên nhầm lẫn với Deep Research của Google) về cơ bản là một tác nhân nghiên cứu hẹp, được xây dựng trên Reasoner o3 chưa được phát hành của OpenAI, và có quyền truy cập vào các công cụ và khả năng đặc biệt. Để hiểu tại sao đây là một trong những AI ấn tượng nhất, hãy đưa cho nó một chủ đề. Giáo sư Ethan đã chọn một vấn đề vừa mang tính kỹ thuật cao vừa gây tranh cãi trong lĩnh vực nghiên cứu của ông: “Khi nào startup nên ngừng khám phá và bắt đầu mở rộng quy mô? Tôi muốn bạn xem xét các nghiên cứu học thuật về chủ đề này, tập trung vào những bài báo chất lượng cao và các thử nghiệm đối chứng ngẫu nhiên (RCTs), đồng thời giải quyết các định nghĩa mơ hồ cũng như những mâu thuẫn giữa quan điểm phổ biến và kết quả nghiên cứu. Trình bày kết quả cho một cuộc thảo luận ở cấp độ sau đại học về vấn đề này.”

AI đặt ra một số câu hỏi thông minh, và ông làm rõ yêu cầu của mình. Sau đó, o3 bắt đầu làm việc. Bạn có thể theo dõi quá trình AI "suy nghĩ" và tiến hành nghiên cứu. Đáng để dành chút thời gian xem một số ví dụ dưới đây – AI thực sự hoạt động như một nhà nghiên cứu, khám phá các phát hiện, đào sâu hơn vào những điều "thú vị" với nó, và giải quyết các vấn đề (như tìm cách thay thế để truy cập các bài báo có tường lửa) Quá trình này kéo dài khoảng năm phút.

Kết quả cuối cùng? Một bản thảo dài 13 trang, 3.778 từ, với sáu trích dẫn chính và một số tài liệu tham khảo bổ sung. “Thành thật mà nói, chất lượng của nó rất tốt”, giáo sư Ethan nhận xét. AI đã kết nối các khái niệm khó và mâu thuẫn một cách khéo léo, phát hiện ra một số mối liên hệ mới mà giáo sư không ngờ tới, chỉ trích dẫn các nguồn học thuật uy tín và chứa đầy những trích dẫn chính xác. Không thể đảm bảo mọi thứ đều đúng (mặc dù giáo sư không thấy lỗi nào), nhưng nếu đây là bài viết của một nghiên cứu sinh tiến sĩ mới vào nghề, ông nhận xét sẽ cảm thấy hài lòng. Bạn có thể xem toàn bộ kết quả tại đây, nhưng chỉ cần vài đoạn trích dưới đây cũng đủ để bạn hiểu vì sao tôi ấn tượng đến vậy.

Một điểm cải tiến quan trọng là chất lượng trích dẫn. Không còn tình trạng AI "bịa" nguồn hay trích dẫn sai – tất cả đều là tài liệu học thuật thực sự, bao gồm những công trình nghiên cứu quan trọng của các đồng nghiệp của giáo sư Ethan Mollick như Saerom (Ronnie) Lee và Daniel Kim. Khi giáo sư nhấp vào các liên kết, chúng không chỉ dẫn đến bài báo gốc mà còn thường đưa ông trực tiếp đến phần có nội dung được trích dẫn. Mặc dù AI vẫn bị giới hạn bởi những gì nó có thể tìm thấy trong thời gian ngắn và các bài báo bị khóa phí vẫn ngoài tầm với, nhưng đây là một bước chuyển đổi căn bản trong cách AI có thể tiếp cận tài liệu học thuật. Lần đầu tiên, một AI không chỉ đơn thuần tóm tắt nghiên cứu mà thực sự tham gia vào quá trình nghiên cứu ở mức độ gần với học thuật con người.

Đáng để so sánh nó với sản phẩm của Google được ra mắt tháng trước cũng có tên là Deep Research. Google đưa ra nhiều trích dẫn hơn, nhưng chúng thường là sự pha trộn của các trang web có chất lượng khác nhau (việc thiếu quyền truy cập vào thông tin có tường lửa và sách ảnh hưởng đến tất cả các tác nhân này). Có vẻ như nó thu thập tài liệu cùng một lúc, trái ngược với quá trình khám phá dựa trên sự tò mò của tác nhân nghiên cứu của OpenAI. Và, vì (cho đến nay) điều này được hỗ trợ bởi mô hình Gemini 1.5 cũ hơn, không có khả năng lập luận, nên tóm tắt tổng thể nông hơn nhiều, mặc dù vẫn chắc chắn và dường như không có lỗi. Nó giống như một bài nghiên cứu xuất sắc của sinh viên đại học, trong khi Deep Research của OpenAI lại ở tầm phân tích gần với cấp độ tiến sĩ. Nếu đọc một chút, bạn sẽ thấy sự khác biệt ngay lập tức.

Để đặt mọi thứ vào bối cảnh: cả hai kết quả đều thể hiện công việc thường tiêu tốn hàng giờ nỗ lực của con người - OpenAI tạo ra phân tích gần trình độ tiến sĩ, trong khi Google cho ra kết quả ở mức sinh viên đại học giỏi. OpenAI đưa ra những tuyên bố táo bạo trong thông báo của họ, kèm theo các biểu đồ cho thấy tác nhân này có thể xử lý 15% các dự án nghiên cứu có giá trị kinh tế cao và 9% các dự án có giá trị rất cao. Mặc dù cần xem xét kỹ phương pháp đo lường của họ, nhưng qua thử nghiệm thực tế, những con số này không quá xa vời. Deep Research thực sự có thể tạo ra những phân tích sâu sắc, có giá trị chỉ trong vài phút thay vì hàng giờ. Và với tốc độ phát triển hiện tại, Google sẽ không để khoảng cách này tồn tại lâu. Trong vài tháng tới, chúng ta có thể sẽ chứng kiến sự cải tiến nhanh chóng của các tác nhân nghiên cứu AI.

Các mảnh ghép hợp lại

Chúng ta có thể thấy rằng những mảnh ghép mà các phòng thí nghiệm AI đang xây dựng không chỉ khớp với nhau mà còn bổ trợ lẫn nhau. Các Bộ lý luận (Reasoners) cung cấp năng lực tư duy, trong khi các hệ thống tác nhân mang đến khả năng hành động.

Hiện tại, chúng ta vẫn đang ở kỷ nguyên của các tác nhân hẹp như Deep Research, bởi ngay cả những Reasoners tốt nhất vẫn chưa đủ khả năng cho sự tự chủ đa năng.

“Nhưng ‘hẹp’ không có nghĩa là ‘hạn chế’ – những hệ thống này đã có thể thực hiện những công việc từng cần đến các nhóm chuyên gia hoặc công ty tư vấn chuyên sâu.” - giáo sư Ethan Mollick.

Tất nhiên, các chuyên gia và công ty tư vấn sẽ không biến mất – thực tế, vai trò của họ sẽ càng quan trọng hơn khi họ chuyển từ trực tiếp làm công việc nghiên cứu sang điều phối và xác minh kết quả mà AI tạo ra. Nhưng các phòng thí nghiệm AI tin rằng đây chỉ mới là khởi đầu. Họ đang đặt cược rằng những mô hình AI tiên tiến hơn sẽ giải mã được bí ẩn của các tác nhân đa năng, mở rộng ra ngoài các nhiệm vụ hẹp để trở thành những "nhân viên kỹ thuật số" tự động, có thể duyệt web, xử lý thông tin từ nhiều nguồn dữ liệu và thực hiện các hành động có ý nghĩa trong thế giới thực. Hiện tại, Operator đã cho thấy chúng ta chưa hoàn toàn đạt đến điều đó, nhưng Deep Research lại cho thấy rằng chúng ta đang đi đúng hướng.

Tác giả: Giáo sư Ethan Mollick

Chuyển ngữ và Biên tập: Hải Loan